【RMILD-576】初体験 ~ミリオン新人デビューコレクション~ 要想获利,AI模子该大该小?贾扬清:论AI模子经济学的妙技

卖模子就像感德节卖火鸡【RMILD-576】初体験 ~ミリオン新人デビューコレクション~,快能力获利。

作家丨刘洁

裁剪丨岑峰

最近的AI社区,对于模子限制的商讨有些活跃。

一方面,此前在大模子开发奉为“圣经”的Scaling Law,似乎正在褪去光环。昨年全球还在揣测GPT-5的限制“可能会大到想不到”,当今这种商讨果然绝迹。大神Andrej Karpathy,则是在感叹大模子限制正在“倒退”。

另一方面,近期市集上性能优秀的微型模子成千上万,参数限制、任务措置、响应速率、安全性能,各公司在不同方面卷了又卷。

究竟是往大作念探索极限,依然往小作念迎阿市集?

这最终汇总成一个问题:在这样模子快速更替的市辘集,要何如能力把LLM模子的营业价值最大化?

1

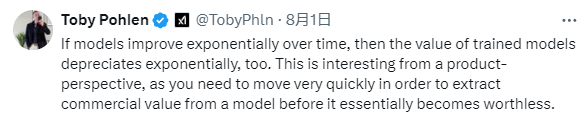

唯快不破的模子业态

最近发起商讨的是X.ai创举成员之一的Toby Pohlen。他合计要是模子以指数级速率蜕变,那么老到模子的价值也会以指数级速率折旧。这也导致东说念主们需要赶在模子更替前就飞速弃取行径获取营业价值,一朝模子产生更新,上一代模子就基本一文不值了。

Toby的这番言论深得雇主Elon Musk之心,大笔一挥打了一个“100分”。

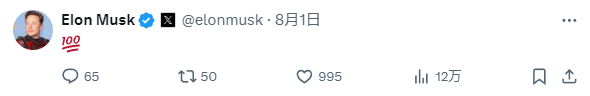

贾扬清也参与到了这场商讨中来,他用感德节火鸡作念了一个兴致的譬如。他淡薄,售卖模子就像是感德节火鸡促销,必须在感德节前夜握紧时辰售卖,幸免在感德节到来后的贬值。新模子的技能更新等于一个又一个感德节,独一销售得更快能力赚到更多的利润。

(emmm...要是对火鸡不好了解,换成中秋节前抢月饼的故事全球概况应该容易明白一些?)

挑剔区也有不少东说念主抒发了对此不雅点的赞同。

暗网人兽有东说念主说只消不休地开发新产物和迭代新模子,就能从中接续获取营业价值。

还有东说念主说,模子蜕变的频率将径直决定模子自己的营业价值。

然而,模子的营业价值由什么决定,又该怎么达成?

2

模子发展在走CNN老路吗?

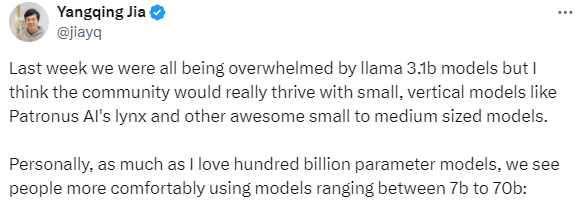

模子必须作念小,用起来才顺遂。

比起大型模子,微型模子资本低利用便利,更能收货营业市集的酷爱。贾扬清就发现,行业趋势在于研发和使用尺寸更小性能苍劲的模子,东说念主们也更郁勃把限制参数在7B-70B之间的中微型模子行为营业使用的弃取。

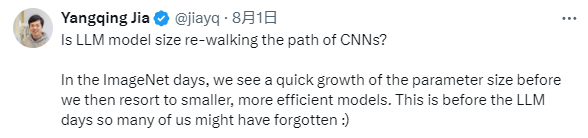

行为前大模子期间的亲历者,贾扬清在当下LLM模子市集上嗅到了熟悉的滋味,先变大再变小变高效,这和CNN时期的模子发展果然一模雷同。

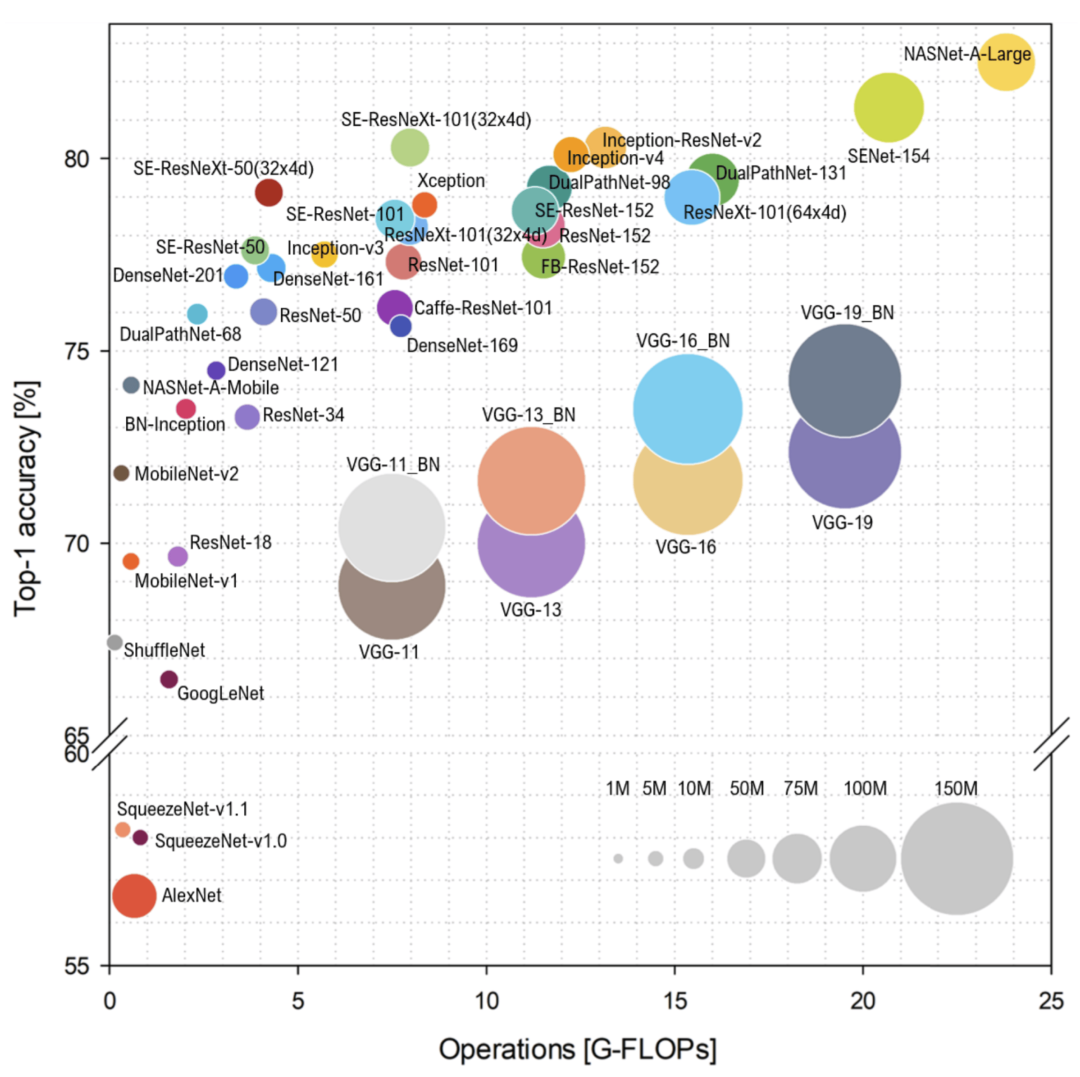

贾扬清还对CNN的发展经过作念了一个简便的先容。

最初是2012年【RMILD-576】初体験 ~ミリオン新人デビューコレクション~,AlexNet开启了模子大小增长的序幕。2014年的VGGNet等于一个限制较大的高性能模子。

到了2015年,模子尺寸启动收缩。GoogleNet 将模子大小从GB降至MB,收缩了100倍,还同期保持了精湛的性能。同庚面世的SqueezeNet也罢职了追求更小尺寸的趋势。

在此之后,模子发展的重心退换到了保管均衡。比如如 ResNet(2015)、ResNeXT(2016)等模子皆保持了一个适中的限制,看管缱绻后果。

贾扬清还先容了CNN的一个兴致的利用,Google的MobileNet(2017),占用空间小性能优胜,还具有出色的特征镶嵌泛化。

临了,贾扬清援用了Ghimire 等东说念主在《高效卷积神经集聚和硬件加快拜谒》里的一张图:

他还进一步提问,LLM模子异日会罢职和CNN雷同的发展趋势吗?

3

大型模子的盈利念念考

不外贾扬清也补充说念,固然行业趋势是模子微型化,但并不虞味着命令全球破除尺寸更大的模子。

但这随之而来的是另一个问题:大型模子的资本会更高。

此前也有东说念主淡薄质疑,对大型模子工作商的运营资本和营运收益作念了简便的缱绻,每天8张H100显卡运营节点的资本约为1000好意思元,每天不错提供2600万token的工作,但按Llama 405B每一百万token 3好意思元的价钱,何如算皆是弃世的,无法盈利的大型模子不会被市集摒弃吗?

贾扬清示意,哎你说这个我就不困了,我熟我来说:)

贾扬清合计,固然每个央求约莫每秒输出30个token,但通过批量措置(同期措置多个央求)不错显赫普及总糊涂量,不错达到比单个央求逾越10倍或更高的糊涂量。

同期他还指出,每秒约莫30个token指的是输出token,大模子对于输入token的措置速率更快,这也加多了措置的总token数,大模子频频对输入和输出差异计费,也恰是这个兴致。

在后续的另一个恢复,贾扬清作念了更瞩想法量化缱绻:

批量输出速率:单并发405b推理频频有每秒30个token的输出速率。合理的并发不错使总糊涂量普及10倍,达到每秒300个token的输出糊涂量。

输入token:输入token也被计费,频频输入token的数目浩大于输出token。一个常见的聊天机器东说念主利用可能有2048个输入token和128个输出token。假定输入输出token比率为10:1,那么每秒300个输出token的措置量罕见于每秒3000个输入token。

价钱:每天统统措置285,120,000个token,按面前Lepton价钱每百万token2.8好意思元缱绻,收入为798.34好意思元。

机器资本:以lambda按需价钱为基准,每张H100卡每小时3.49好意思元,8张H100卡一天的资本为670.08好意思元。

收入798.34好意思元,资本670.08好意思元,因此通过整合多种技能局面,在合理流量下(像Lepton这样的大模子技能工作商)是可能盈利的。

天然,这仅仅一个简便的推算,本色的盈利还会受到流量踏实性、计费形貌、按需使用GPU的机器资本截至、解码、领导缓存以偏激他身分的影响。

但某种进度上说,访佛深度学习期间对CNN的不休优化,在大模子期间,也需要技能东说念主员对于模子进行各样优化,来保证性能普及的同期不休缩短资本,这恰是贾扬清看好的创业蹊径。

4

One more thing

咱们不妨再多商讨一下,对于贾扬清这样的AI Infra创业者,模子大小的潮水变化对他的营业款式有什么影响?

这个问题,要分不怜悯况分析。

要是模子参数目越大,提供模子工作的门槛越高(参考Llama 405B),其客单价天然也就越大;

另一方面,由于好多小模子本色是在大模子的基础上蒸馏而得到,模子小了,所需的缱绻资源并莫得等幅度减少;

由于较小的模子更容易部署在不同的斥地和平台上,这可能会带来利用场景的加多,固然客单价可能缩短,但在需求数目上的加多反而可能使得总收入加多;

对于贾扬清来说,META的开源蹊径使得贾扬清的工作对象扩大,因此开源对他来说更故意。

看来岂论异日模子限制何如不变化,贾扬清皆有契机凭借技能升级稳坐垂纶台。这有点像之前的中国股市,岂论什么音尘,皆是“利好茅台”啊。

这只怕等于贾扬清最近在推特上为什么这样活跃发表认识的原因?你看好贾扬清这种AI Infra的创业蹊径吗?(接待添加微信zkkkue,相易最新AI行业动态。)

参考尊府:

https://x.com/jiayq/status/1818902164938670206

https://x.com/TobyPhln/status/1818686287475282260

https://x.com/elonmusk/status/1818686692905435406

https://x.com/jiayq/status/1818703217263624385

https://x.com/jiayq/status/1818699120049311883

https://x.com/jiayq/status/1818704837745557912

https://x.com/jiayq/status/1817092427750269348

头图/封面起首于贾扬清X(https://x.com/jiayq/status/1818907312851169748)

更多内容,点击下方关心:

]article_adlist-->

未经「AI科技挑剔」授权,严禁以任何形貌在网页、论坛、社区进行转载!

]article_adlist-->公众号转载请先在「AI科技挑剔」后台留言取得授权,转载时需标注起首并插入本公众号柬帖。]article_adlist--> 海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP